Mohamed Daoudi, IMT Lille Douai – Institut Mines-Télécom

Bienvenue dans une nouvelle ère, celle de la biométrie faciale. La mise sur le marché de l’iPhone X, un smartphone qui possède une fonctionnalité de reconnaissance faciale, Face ID, a montré que cette technologie atteint aujourd’hui une pleine maturité. Cela grâce à l’arrivée de capteurs 3D miniaturisés et à une puissance de calcul très importante à son service, combinée à des algorithmes d’apprentissage très performants tels que l’apprentissage profond (Deep Learning).

De quoi parle-t-on lorsqu’on évoque la reconnaissance faciale ? Cela consiste à repérer que deux visages sont identiques malgré des changements dus aux conditions d’éclairage, de pose et d’expressions faciales. En général, cela consiste à trouver une distance entre les visages telle qu’elle puisse être utilisée pour identifier tous les changements du visage.

En 2014, des chercheurs de Facebook ont publié un article appelé « DeepFace : Closing the Gap to Human-Level Performance in Face Verification ». Afin d’éviter les problèmes liés au changement de la pose, une phase d’alignement du visage 2D sur un modèle de visage 3D est utilisée. La phase suivante est un processus d’apprentissage profond par un réseau de neurones artificiels constitué de 120 millions de connexions. L’ensemble d’apprentissage est constitué de 4,4 millions de visages de célébrités. Ce réseau de neurones a été entraîné pour appréhender les variabilités des visages. L’algorithme permet de déterminer si deux visages photographiés appartiennent à la même personne avec une précision annoncée de 97,35 %.

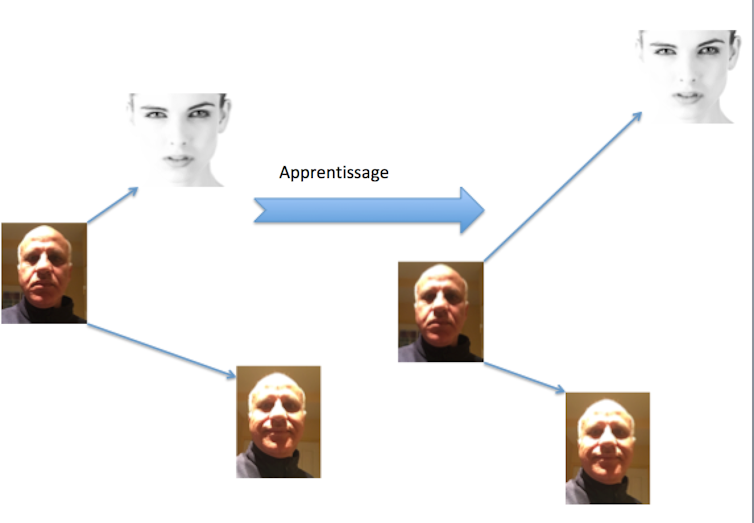

En 2015, des chercheurs de Google ont publié un article intitulé « FaceNet : A Unified Embedding for Face Recognition and Clustering ». Ils ont montré qu’ils étaient capables d’atteindre un taux de reconnaissance de l’ordre de 99,63 % sur une base de données de visages en deux dimensions acquise dans un environnement non contrôlé. Pour réussir, les auteurs proposent un réseau de neurones constitué de onze couches à convolution et trois couches connectées. L’idée est de s’assurer qu’une image d’une personne spécifique est plus proche de toutes les autres images de la même personne (dites positives) que des images d’autres personnes (dites négatives). L’apprentissage a été effectué sur une base de 200 millions de visages de 8 millions de personnes.

Cependant, les expériences DeepFace et FaceNet se fondent toutes deux sur des bases de données privées qui ne sont pas disponibles pour la communauté scientifique. Une équipe de l’université d’Oxford a proposé de collecter des données du Web et a constitué une base de données de 2,6 millions de visages issue de 2 622 personnes et a proposé une architecture de réseaux de neurones appelée VGG-Face constituée de 16 couches de convolution et 3 couches entièrement connectées. Aujourd’hui cette architecture est très largement utilisée par la communauté de vision par ordinateur.

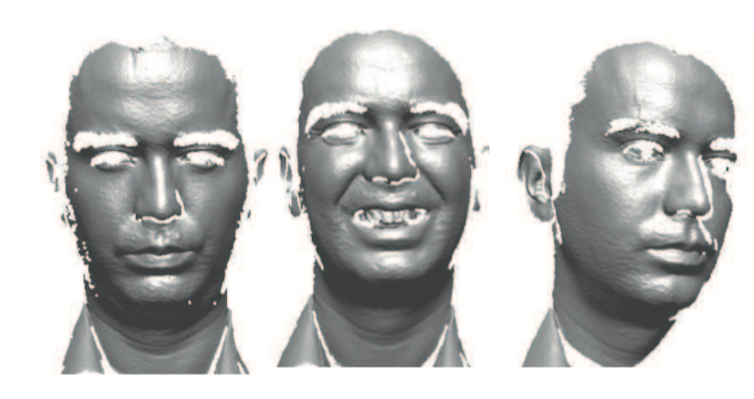

Cependant, le visage n’est pas qu’une image 2D mais aussi une image tridimensionnelle en 3D. La biométrie faciale peut s’y appliquer puisque les technologies de scan 3D permettent de scanner un visage. L’avantage majeur de l’utilisation de la 3D dans ce cadre est que les algorithmes de reconnaissance du visage sont robustes aux changements d’éclairage et de pose. Des travaux récents publiés par notre équipe de l’IMT Lille Douai dans la revue IEEE TPAMI en 2013 « 3D face recognition under expressions, occlusions, and pose variations » ont montré l’intérêt de ce procédé. Dans cet article, nous avons proposé de comparer deux visages 3D en comparant deux ensembles de courbes qui représentent localement la forme d’un visage 3D. Nous avons obtenu un taux de reconnaissance de l’ordre de 97 % (sur la base Face Recognition Grand Challenge). Les résultats obtenus sur plusieurs bases de tests internationaux montrent tout l’intérêt du visage 3D dans les systèmes de biométrie faciale.

![]() Revenons à l’iPhone X et à sa technologie 3D pour la reconnaissance faciale. Une prouesse rendue possible par l’introduction de capteurs 3D miniaturisés sur la face avant de l’appareil : un projecteur envoie 30 000 points invisibles sur le visage de son utilisateur, utilisés pour modéliser le visage 3D. D’après Apple, Face ID ne peut pas être trompé par une simple photo de visage, puisque la reconnaissance se fait avec un capteur 3D qui prend donc en compte la profondeur.

Revenons à l’iPhone X et à sa technologie 3D pour la reconnaissance faciale. Une prouesse rendue possible par l’introduction de capteurs 3D miniaturisés sur la face avant de l’appareil : un projecteur envoie 30 000 points invisibles sur le visage de son utilisateur, utilisés pour modéliser le visage 3D. D’après Apple, Face ID ne peut pas être trompé par une simple photo de visage, puisque la reconnaissance se fait avec un capteur 3D qui prend donc en compte la profondeur.

Mohamed Daoudi, Professeur à l’IMT Lille Douai, Centre de recherche en informatique, signal et automatique de Lille, IMT Lille Douai – Institut Mines-Télécom

La version originale de cet article a été publiée sur The Conversation.

I'MTech L'actualité scientifique et technologique de l'IMT

I'MTech L'actualité scientifique et technologique de l'IMT

One comment

Pingback: Mohamed Daoudi - I'MTech